Was ist Reinforcement Learning?

Reinforcement Learning ist ein Zweig des maschinellen Lernens, der sich mit dem Problem der sequentiellen Entscheidungsfindung beschäftigt.

Reinforcement Learning ist ein Zweig des maschinellen Lernens, der sich mit dem Problem der sequentiellen Entscheidungsfindung beschäftigt.

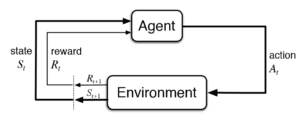

In seiner allgemeinsten Form untersucht es das Problem eines Agenten, der mit der Außenwelt (d. h. der Umwelt) interagiert, indem er bei jedem Schritt eine Aktion ausführt. Die Wahl der Aktion hat Konsequenzen: Erstens führt sie zu einem neuen Zustand für den Agenten; und zweitens erhält der Agent ein Belohnungssignal von der Umwelt, das ihm sagt, wie gut oder schlecht die Aktion war. Das Ziel des Agenten ist es, herauszufinden, wie er sich verhalten soll, d.h. was die beste Aktion in jedem Zustand ist, so dass er langfristig die höchstmögliche Menge an Belohnungen erhält.

Das Schlüsselwort hier ist "langfristig": Die Aktion, die zu sofortiger Zufriedenheit führt, ist nicht unbedingt gut für den langfristigen Erfolg. Das ist Teil der Komplexität, die die RL-Lernalgorithmen zu adressieren versuchen: Der Agent hat anfangs keine Ahnung, wie gut oder schlecht eine Aktion ist (z. B. wie viel unmittelbare Belohnung sie erzeugen wird) und welche nächsten Zustände sie erzeugen wird. Der Agent muss auf ausgewogene Weise den Aktionsraum erkunden, um die Auswirkungen jeder Aktion zu erfahren, und gleichzeitig die beste Aktionsstrategie herausfinden, die zur höchstmöglichen langfristigen Belohnung führt. Der Prozess des Herausfindens der besten Handlungsstrategie unter Verwendung einer Trainingsmenge solcher Agentenerfahrungen ist das ultimative Ziel des Reinforcement Learning.

Denken Sie zum Beispiel an ein selbstfahrendes Auto: Während der Fahrt muss es in jedem Moment wissen, welche Aktionen es durchführen soll (soll ich bremsen? Soll ich rechts abbiegen? Soll ich weiter geradeaus fahren? Warum nicht einfach beschleunigen?). Um damit zu beginnen, müssen wir einen Belohnungswert definieren, der uns sagt, wie gut oder schlecht jede Aktion war (bin ich näher am Ziel? Bin ich sicher genug? Konnte ich beim Einparken dem Bordstein ausweichen?). RL-Algorithmen sind in der Lage, dem Auto beizubringen, wie es seine langfristigen Belohnungen durch optimale Aktionen maximieren kann (d. h. wie es fahren soll).

Reinforcement Learning hat eine lange Geschichte als Zweig der Informatik und des maschinellen Lernens. Seine Kernideen wurden in den letzten 30 Jahren entwickelt, aber aufgrund seiner Komplexität konnte es nur auf Probleme mit relativ kleinen Zustands- und Aktionsräumen angewendet werden.

Die Einbindung von Deep Learning in RL öffnete die Tür zur Lösung von realen Problemen mit RL, bei denen Zustands- und Aktionsräume sehr groß sein können.

DeepMind war die erste Gruppe, die die Leistungsfähigkeit von Deep RL zeigte, als 2016 der von ihnen trainierte spielende Agent den Weltmeister im Spiel Go schlug. Es gibt auch eine große Anzahl von Anwendungsfällen für RL in verschiedenen Branchen, z. B. im Finanzwesen, im Gesundheitswesen und in der digitalen Werbung.

Real-Time Bidding (RTB) ist ein Mechanismus zur Verbindung von Werbetreibenden mit Online-Publishern. Das Ziel der Publisher ist es, die von ihnen generierten Inhalte zu monetarisieren. Das Ziel der Werbetreibenden ist es, ihre Budgets optimal auszugeben, so dass einige vorher festgelegte Ziele erreicht werden. Der Prozess der Zuteilung von Werbebudgets wird auf einer hochgranularen Ebene bestimmt, Impression für Impression, in Echtzeit-Auktionsprozessen, die milliardenfach pro Tag stattfinden.

Die Gebotsstrategie einer Werbekampagne bestimmt in Echtzeit, wie viel für die Chance geboten wird, die Botschaft eines Werbetreibenden einem bestimmten Nutzer zu zeigen. Dieses Gebot muss auf der Grundlage aller möglichen Merkmale der Werbemöglichkeit bestimmt werden, z. B.: Um welche Webseite oder App handelt es sich? Was ist der geografische Standort? Was ist die Tageszeit oder der Wochentag?

Und als ob das Problem nicht schon komplex genug wäre, sollte die Gebotsstrategie auch vordefinierte Key Performance Indicators (KPIs) Ziele liefern (denken Sie an Gesamtbudgets oder Leistungsziele, die durch CPA, CPC, etc. ausgedrückt werden), die im Auftrag des Werbetreibenden festgelegt werden.

Wir von der Copilot-Gruppe bei Xaxis nutzen maschinelles Lernen/AI als Kern unserer Gebotsstrategien: Es hilft uns, aus historischen Daten Anhaltspunkte zu lernen, wie die Gebotswerte gesetzt werden müssen. Unsere Vision ist, dass das Ziel der optimalen Gebotsstrategie sein sollte, den vordefinierten Zielen des Werbetreibenden so nahe wie möglich zu kommen. Um dies zu erreichen, müssen wir die Parameter der Gebotsstrategie dynamisch anpassen, so dass sie die KPIs kontinuierlich in die richtige Richtung bewegt.

Es stellt sich heraus, dass RL ein ideales Werkzeug ist, um die Herausforderung des dynamischen Managements einer Werbekampagne anzugehen. Dieses Problem ist im Kern ein sequentielles Entscheidungsproblem: Wie sollte man am besten die Kampagnenattribute - sequentiell - anpassen, so dass das Ziel der vollständigen KPI-Lieferung erreicht wird?

Ein grober Aufbau der dynamischen Anpassung von Gebotsstrategien als RL-Problem sieht folgendermaßen aus:

Unser Copilot-Team bei Xaxis erforscht und testet aktiv die Anwendung von Deep RL für Trainingskampagnen. Weitere Ergebnisse werden wir in einem kommenden Beitrag vorstellen.