Making decisions is hard. When you choose a restaurant, do you fall back on favorites or try something new? With the regular spots you know what you’re getting, so you’re lowering your chance of regret. But you could be missing out on something better. On the other hand, exploring a new restaurant increases your risk of suffering through sad and soggy scallion pancakes. We call the former behavior “exploitation” and the latter “exploration” -- essentially, exploiting the information you have versus exploring for new data. Exploitation and exploration have to be balanced for you to have a decent shot at sustainable, successful decision-making.

En la publicidad online, podemos enfrentarnos al problema de elegir entre diferentes modelos o estrategias de puja para una campaña publicitaria. ¿Cómo se debe equilibrar la explotación y la exploración para conseguir el mejor rendimiento?

We recently published a paper on how to address this problem with our Automatic Model Selector (AMS). It’s a system for scalable online selection of bidding strategies based on live performance metrics. Yes, a human can set up multiple bidding strategies -- but AMS can choose the right one at the right time as needed to maximize performance. It automatically balances explore-exploit.

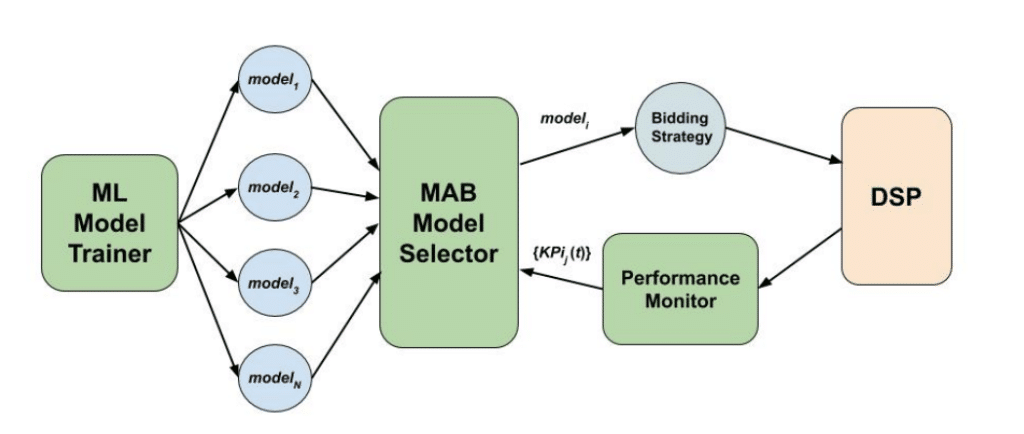

El sistema emplea el método de los bandidos multiarmados (MAB) para ejecutar y evaluar continuamente varios modelos contra el tráfico en vivo, asignando la mayor parte del tráfico al modelo de mejor rendimiento y disminuyendo el tráfico a los de peor rendimiento. Explora dando un tráfico distinto de cero a todos los modelos para que cada uno de ellos pueda ser evaluado, y explota poniendo la mayor parte del tráfico en el modelo con mejor rendimiento. El alcance de la explotación aumenta con el tiempo a medida que el sistema adquiere más confianza en el modelo que mejor funciona. Esta figura ofrece una visión general de los componentes del sistema AMS:

Figura 1. Componentes del sistema MAB. El Entrenador de Modelos ML proporciona modelos ML entrenados como las armas disponibles para el algoritmo MAB, ejecutado por el Selector de Modelos MAB. El modelo seleccionado alimenta un algoritmo de puja para una campaña RTB en vivo que se ejecuta en un DSP. Los KPIs de rendimiento de la campaña son seguidos por el Monitor de Rendimiento, en base al cual se actualizan las probabilidades de selección de los brazos. Los modelos se intercambian cada 15 minutos y los KPI de rendimiento se actualizan una vez al día.

En comparación con el proceso tradicional de evaluación de modelos, que dependía en gran medida de los humanos, el AMS tiene algunas ventajas:

- AMS evalúa de forma regular y automática el rendimiento del modelo con datos online utilizando sus métricas de medios (por ejemplo, CTR, CPC, etc.). Así se evita la posibilidad de basarse en datos antiguos o anticuados, así como la incoherencia entre las métricas de medios y las de aprendizaje automático.

- AMS es flexible. Realiza la selección del modelo para cada campaña individualmente en lugar de elegir un modelo y aplicarlo a todas las campañas. Los modelos más simples pueden funcionar mejor para las campañas pequeñas, mientras que los modelos complejos pueden ser necesarios para las campañas más grandes. AMS puede encontrar el modelo que mejor funcione para cada campaña en función de la situación específica del anunciante o del mercado.

- AMS es escalable. Ahorra tiempo al ser autosuficiente en la ejecución de experimentos controlados y permite a las personas centrarse en la estrategia de alto nivel. AMS evalúa a los candidatos a modelo caso por caso y aplica sistemáticamente las conclusiones a los modelos de turno.

Este sistema ha demostrado su eficacia en los primeros experimentos en línea. Aunque el AMS todavía no se refleja en nuestro producto en vivo, esta investigación está alimentando nuestro proceso de pensamiento para las innovaciones que vendrán. Si está interesado en conocer los detalles de AMS, o los resultados del experimento en línea, puede encontrar la información en nuestro documento publicado: Online and Scalable Model Selection with Multi-Armed Bandits.